5月13日,点冷机在零一万物成立一周年之际,零一万物 CEO 李开复博士携带千亿参数 Yi-Large 闭源模型正式亮相,正式进军全球 SOTA 顶级大模型之首,在斯坦福最新的 AlpacaEval 2.0 达到全球大模型 Win Rate 第一。

除此之外,零一万物将早先发布的 Yi-34B、Yi-9B/6B 中小尺寸开源模型版本升级为 Yi-1.5 系列,每个版本达到同尺寸中 SOTA 性能最佳。

在国际领先的底座模型之上,零一万物本月同步官宣了从应用到生态的产品线:2C 生产力应用 “万知” 正式提供服务、赋能 2B 生态的 “API 开放平台” 今日全球上线。借一周年发布会,零一万物公开了开源闭源双轨大模型的战略布局,低调许久的创始人李开复也首度现身说法,亲自拆解发展蓝图背后的战略思路。

在中国大模型进入第二年之际,李开复博士提出,国内大模型赛道的竞跑从狂奔到长跑,终局发展将取决于各个选手如何有效达到 “TC-PMF”(Product-Market-Technology-Cost Fit,技术成本 X 产品市场契合度)。大模型从训练到服务都很昂贵,算力紧缺是赛道的集体挑战,行业应当共同避免陷入不理性的 ofo 式流血烧钱打法,让大模型能够用健康良性的 ROI 蓄能长跑,奔赴属于中国的 AI 2.0 变革。

零一万物以全球为目标市场,基于全球领先的 Yi 系列模型做出符合 TC-PMF 的B端和C端优质应用,进而与行业携手推进 AI 2.0 生态。中国市场的AI普惠必然到来,零一万物将结合国际经验,打造惊艳的国内 AI-First 应用生态,实现“让通用人工智能普惠各地,人人受益”的公司愿景。

Yi-Large 进击全球SOTA大模型极品,Win Rate全球第一

去年11月,零一万物所发布的 Yi-34B 以开源社区“甜点级”尺寸在权威榜单中超越了 Llama2-70B、Falcon-180B等大几倍的模型,成为当时世界范围内开源最强基础模型之一。

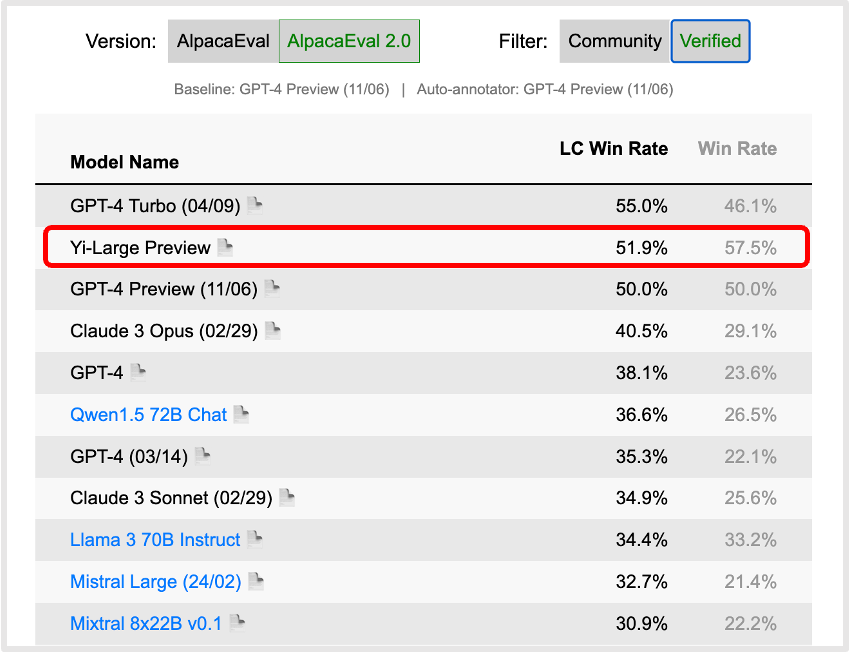

半年后,零一万物正式发布千亿参数规模的 Yi-Large,在第三方权威评测中,零一万物 Yi 模型在全球头部大模型的中英文双语 PK 上表现出色。最新出炉的斯坦福评测机构 AlpacaEval 2.0 经官方认证的模型排行榜上,Yi-Large 模型的英语能力主要指标 LC Win Rate(控制回复的长度) 排到了世界第二,仅次于 GPT-4 Turbo,Win Rate 更排到了世界第一,此前国内模型中仅有 Yi 和 Qwen 曾经登上此榜单的前 20。

斯坦福 AlpacaEval 2.0 Verified 认证模型类别,英语能力评测(2024年5月12日)

在中文能力方面,SuperCLUE 更新的四月基准表现中,Yi-Large 也位列国产大模型之首,Yi-Large 的综合中英双语能力皆展现了卓越的性能。

在更全面的大模型综合能力评测中,Yi-Large 多数指标超越 GPT4、Claude3、Google Gemini 1.5 等同级模型,达到首位。在通用能力、代码生成、数学推理、指令遵循方面都取得了优于全球领跑者的成绩,稳稳跻身世界范围内的第一梯队。随着各家大模型能力进入到力求对标GPT4的新阶段,大模型评测的重点也开始由简单的通用能力转向数学、代码等复杂推理能力。在针对代码生成能力的 HumanEval、针对数学推理能力的 GSM-8K和 MATH、以及针对领域专家能力的GPQA等评测集上,Yi-Large也取得了具有绝对优势的成绩。

值得注意的是,上述评测均是在零样本(0-shot)或少样本(4-shot/5-shot/8-shot)的前提下进行。在零样本或少样本的情况下,模型必须依赖于其在大量数据上训练时获得的知识和推理能力,而不是简单地记忆训练数据。这最大程度上避免了刷分的可能性,能更加客观真实地考验模型的深层次理解和推理能力。

此外,从行业落地的角度来看,理解人类指令、对齐人类偏好已经成为大模型不可或缺的能力,指令遵循(Instruction Following)相关评测也越发受到全球大模型企业重视。斯坦福开源评测项目 AlpacaEval 和伯克利 LM-SYS 推出的 MT-bench 是两组英文指令遵循评测集,AlignBench 则是由清华大学的团队推出的中文对齐评测基准。在中外权威指令遵循评测集中,Yi-Large 的表现均优于国际前五大模型。

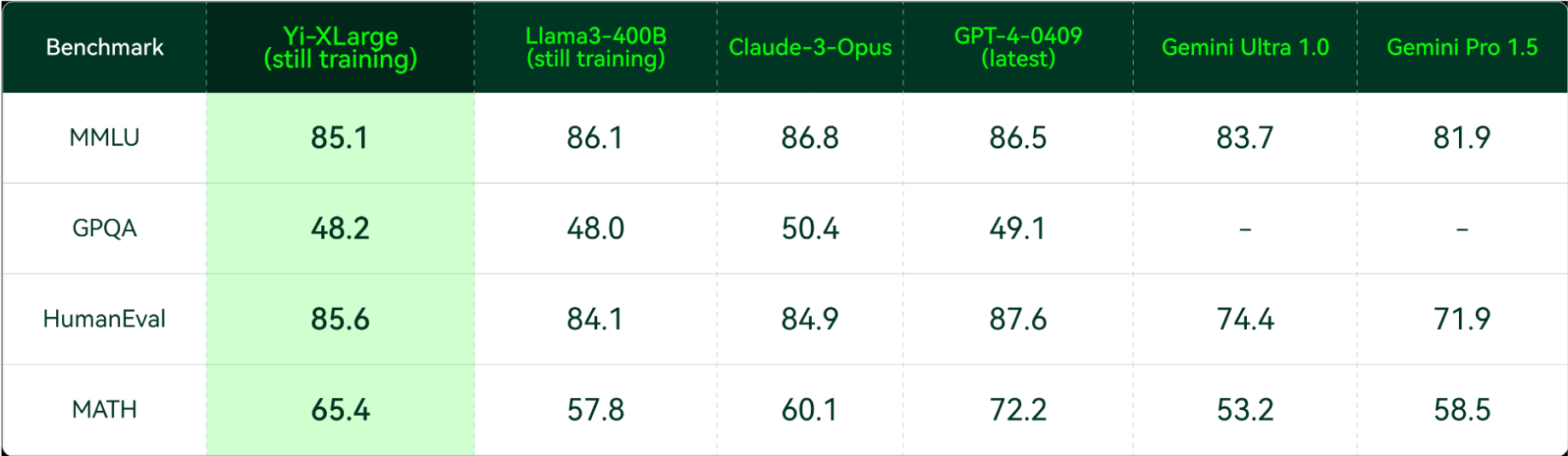

发布会上,李开复博士还宣布,零一万物已启动下一代 Yi-XLarge MoE 模型训练,将冲击 GPT-5 的性能与创新性。从 MMLU、GPQA、HumanEval、MATH 等权威评测集中,仍在初期训练中的 Yi-XLarge MoE 已经与 Claude-3-Opus、GPT4-0409 等国际厂商的最新旗舰模型互有胜负,训练完成后的性能令人期待。

Yi-XLarge 初期训练中评测(2024年5月12日)

Yi-1.5 开源全面升级,开源闭源双轨完善生态策略

此次发布会上,零一万物Yi系列开源模型也迎来全面升级,Yi-1.5 分为 34B、9B、6B 三个版本,且提供了 Yi-1.5-Chat 微调模型可供开发者选择。从评测数据来看,Yi-1.5 系列延续了 Yi 系列开源模型的出色表现,数学逻辑、代码能力全面增强的同时,语言能力方面也保持了原先的高水准。

经过微调后的 Yi-1.5-6B/9B/34B-Chat 在数学推理、代码能力、指令遵循等方面更上一层楼。Yi-1.5-6B/9B-Chat 在 GSM-8K 和 MATH 等数学能力评测集、HumanEval 和 MBPP 等代码能力评测集上的表现远同参数量级模型,也优于近期发布的 Llama-3-8B-Instruct;在 MT-Bench、AlignBench、AlpacaEval 上的得分在同参数量级模型中也处于领先位置。

Yi-1.5-34B-Chat 在数学能力同样保持着大幅领先,代码能力与超大参数量级的 Mixtral-8x22B-Instruct-v0.1 持平,指令遵循方面更是在 MT-Bench、Alignbench、ArenaHard、AlpacaEval2.0 等多个权威评测集上完全超越了 Mixtral-8x22B-Instruct-v0.1。

去年零一万物选择以开源首发 Yi 系列模型,其优异的性能受到国际开发者的高度认可。Yi 开源版本2023年11月上线首月,便占据开源社区近5成热门模型排行,发布一个月后 Yi-34B 被 Nvidia 大模型 Playground 收录,成为国内唯一获选模型,也建立了 Yi 模型面向国际的科技品牌信任度。

以开源模型构建生态,以闭源模型展开 AI-First 探索,开源闭源双轨模型策略使得零一万物构建起了生态体系。开源模型服务于全球的科研院校、学生、开发者、创业者人群,推动百花齐放的应用滋长;API 开放平台提供企业商用,协助企业实践 AI 2.0 的智能化转型。

同时,零一万物以优异的闭源模型能力,正在积极探索与世界 500 强企业的大型战略合作。开源闭源相互助力,确保零一万物本着 TC-PMF 的方法论,以更稳健的步伐奔向 AGI。

Yi 大模型 API 开放平台全球首发

全球开发者们对开源模型的品牌认可,成为零一万物 API 服务的强有力支撑。今天,零一万物宣布面向国内市场一次性发布了包含 Yi-Large、Yi-Large-Turbo、Yi-Medium、Yi-Medium-200K、Yi-Vision、Yi-Spark 等多款模型 API 接口,保证客户能够在不同场景下都能找到最佳性能、最具性价比的方案,Yi API Platform 英文站同步对全球开发者开放试用申请。

Yi 大模型 API 开放平台

其中,千亿参数规模的 Yi-Large API 具备超强文本生成及推理性能,适用于复杂推理、预测,深度内容创作等场景;Yi-Large-Turbo API 则根据性能和推理速度、成本,进行了平衡性高精度调优,适用于全场景、高品质的推理及文本生成等场景。

Yi-Medium API 优势在于指令遵循能力,适用于常规场景下的聊天、对话、翻译等场景;如果需要超长内容文档相关应用,也可以选用 Yi-Medium-200K API,一次性解读20万字不在话下;Yi-Vision API 具备高性能图片理解、分析能力,可服务基于图片的聊天、分析等场景;Yi-Spark API 则聚焦轻量化极速响应,适用于轻量化数学分析、代码生成、文本聊天等场景。

万知 “AI-First 版 Office” 帮你找、读、写

近期上线的一站式 AI 工作站“万知”(wanzhi.com 微信小程序“万知AI”)则是零一万物基于世界领先的闭源模型 Yi-Large 所做出的 “模应一体” 2C 生产力应用。依托零一万物闭源模型的强大能力,万知在通用问答、多模态、长文本方面都有着不俗表现。更令人惊喜的是,万知成为业内第一款真正实践了“AI-First”理念、创新性地将模型能力与应用场景完美融合的 2C 应用产品。

以往发布的大模型 2C 应用大多定位于“聊天机器人”,万知则针对找、读、写三大场景,将通用问答场景作为交互方式,搭配长文档解读、PPT 制作等功能,打造PC/手机多端协同、覆盖工作生活全场景的 “AI-First 版 Office”,为用户提供 AI 2.0 时代颠覆性的办公体验,创始人李开复也亲自担任“首席体验官” 聆听网友反馈。

大模型赛道从狂奔到长跑,需有达到 TC-PMF 的方法论

在移动互联网的鼎盛时期,PMF(Product-Market Fit,产品市场契合)曾是众多初创企业追求的核心目标。然而,随着大语言模型成为新的创业焦点,仅仅追求产品与市场契合远远不够。

两个时代在创业基础设施层面存在着决定性的差异——在移动互联网时代,用户规模增长所带来的边际成本很低,但是在大模型时代,模型训练和推理成本构成了每一个创业公司必须要面临的增长陷阱。用户增长需要优质的应用,而优质应用离不开强大的基座模型,强大基座模型的背后往往是高昂的训练成本,接着还需要考虑随用户规模增长的推理成本。这一普惠点如何达成、何时到来变得越发难以捉摸。

李开复博士认为,PMF 这一概念已经不能完整定义以大模型为基础的 AI-First 创业,应当引入 Technology(技术)与 Cost(成本)组成四维概念——TC-PMF。“做 Technology-Cost Product-Market-Fit(TC-PMF),技术成本 X 产品市场契合度,尤其推理成本下降是个‘移动目标’,这比传统 PMF 难上一百倍。” 李开复博士表示。

随着高性能计算硬件的迭代和模型优化技术的普及,大模型推理成本的大幅度下降已经成为可预见的趋势所在。在普惠点终将到来的前提下,能够率先察觉、并达到 TC-PMF 这一普惠点的玩家无疑会占尽先机。要做到这一点,模型、AI Infra、应用这“三位一体” 的优异能力缺一不可。基于此,零一万物将 “模基共建”、“模应一体”列为公司的顶层核心战略,在人才密度和协作方式上,也快速打磨出一整套能够媒合不同专业的精英人才进行跨界共创的组织能力。